對影完整視覺感受,Google 以 46 組相機完整記錄 3D 影像

【此文章來自:Mashdigi】

由於採用光場影像記錄,因此將能保留真實影像視覺感受內容,例如在不同視角下的遠近感,以及行進間的視差感受,另外在光影折射表現也能完整還原。

整部拍攝裝置除了以 46 組相機設備構成,並且以每組相機間隔 18 公分形式構成直徑 92 公分的 20 面半球體,記錄視角則可達 220 度以上。而在拍攝過程中,將會進行影像壓縮及後續渲染處理,其中以 DeepView 類神經網路學習方式讓影像拼接變得更自然、正確。

最後生成的多球狀影像 (MSI,Multi-sphere image),將會以 100 張以上的高解析度 RGBA (RGB+Alpha) 影像組成單一畫格內容,並且透過 Layered Mesh (LM) 格式壓縮,使最終生成影像能對應串流播放使用需求,藉此能串流至手機上播放觀看。

同時,因為壓縮後的檔案佔比相當小,因此可藉由串流形式傳送到手機、網頁,或是頭戴裝置上觀看,藉此推動更廣泛的虛擬視覺應用。

藉此推動更多元的虛擬視覺應用

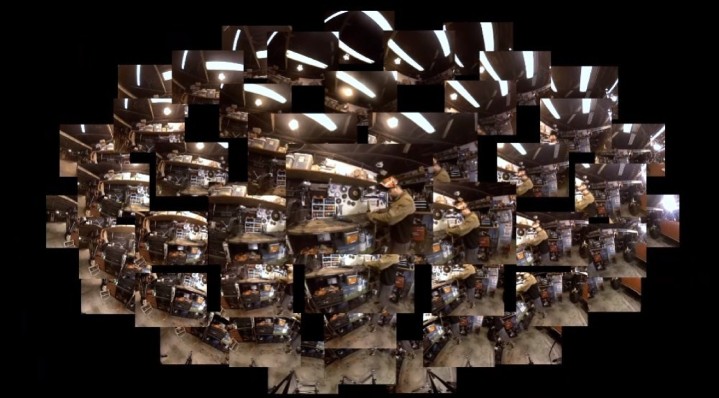

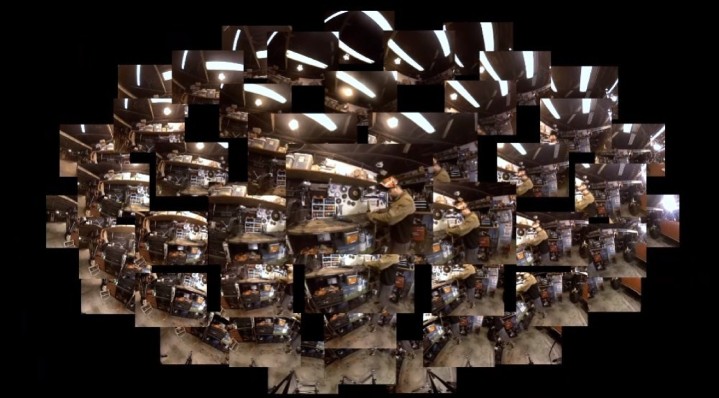

雖然去年宣布終止以多組攝影機拍攝 360 度環景影像的 JUMP 計畫,但顯然 Google 並未放棄拍攝立體影像的技術發展。在 SIGGRAPH 2020 所釋出技術白皮書內,Google 提出以多疊重現的沉浸光場影片格式 (Immersive Light Field Video with a Layered Mesh Representation),透過 46 組相機設備捕捉光場影像資訊,並且透過機器學習等軟體技術重建可對應 6 自由度 (6DoF) 觀看的立體影像。

由於採用光場影像記錄,因此將能保留真實影像視覺感受內容,例如在不同視角下的遠近感,以及行進間的視差感受,另外在光影折射表現也能完整還原。

整部拍攝裝置除了以 46 組相機設備構成,並且以每組相機間隔 18 公分形式構成直徑 92 公分的 20 面半球體,記錄視角則可達 220 度以上。而在拍攝過程中,將會進行影像壓縮及後續渲染處理,其中以 DeepView 類神經網路學習方式讓影像拼接變得更自然、正確。

最後生成的多球狀影像 (MSI,Multi-sphere image),將會以 100 張以上的高解析度 RGBA (RGB+Alpha) 影像組成單一畫格內容,並且透過 Layered Mesh (LM) 格式壓縮,使最終生成影像能對應串流播放使用需求,藉此能串流至手機上播放觀看。

同時,因為壓縮後的檔案佔比相當小,因此可藉由串流形式傳送到手機、網頁,或是頭戴裝置上觀看,藉此推動更廣泛的虛擬視覺應用。

廣告

網友評論 0 回覆本文