為何單鏡頭拍照這麼好?Google Pixel 四大相機技術解密大公開

Google 的 Pixel 手機在相機的規格上,目前都只靠著單一鏡頭的拍照方式,同樣在 DxOMark 的評比上獲得不錯的成績,而 Google 最大的秘密,就在在相機的演算法上花了相當大的功夫,在鏡頭的設計上並非只靠光學設計來拍攝照片,而是透過背後一套獨門的演算法來呈現照片的質量。

今天我們就來為大家解密,究竟 Google 在 Pixel 上,連同 Google Lens 上究竟有什麼秘密,可以透過單鏡頭拍攝如此驚艷的照片。

這次 Google 台灣特別請來了 Google 傑出工程師 Marc Levoy 博士,他是史丹佛大學電腦科學榮譽退休教授(

在進入 Google 相機技術的秘密之前,Marc 先跟我們聊到,現在的相機趨勢的部分,在過去各家都是靠著鏡頭光學的硬體設計來打造相機,但是在進入手機的時代由於物理限制的關係,技術開始慢慢地往軟體修正為主,拍照已經不能純靠純光學來呈現影像。

而 Google 打造的相機除了有一定水準的光學品質之外,在軟體的部分也下了相當大的功夫。Google 在拍攝軟體當中導入了機器學習的部分,而機器學習就是運用大量的 AI 來取代傳統的演算法,在長間的使用下,機器會獲取到更多的數據與資訊,提升整體的執行準確度。

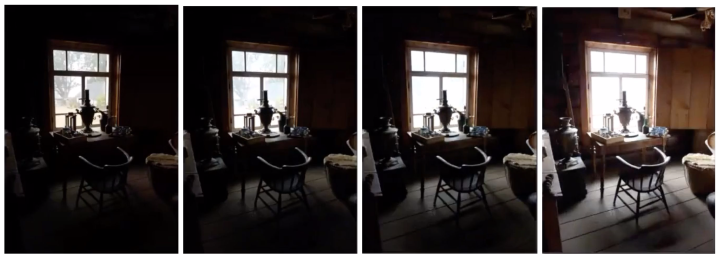

▲ 傳統的 HDR 合成方式,透過不同曝光程度的照片合成影像,但是這樣的方法需要上三腳架才能獲得穩定的影像。

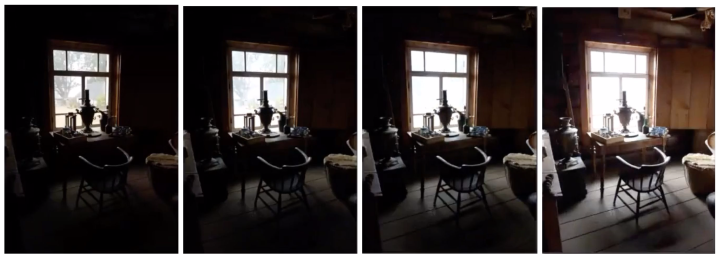

▲ Google HDR+ 的拍攝方式,保留了亮部的細節以及減少暗部雜訊的產生。

但是從在 Google Pixel 2 開始到現在的 Google Pixel 3 系列,在手機只有單一鏡頭的情況下,只需要透過下面兩種技術就能獲得同樣甚至更棒的景深效果:

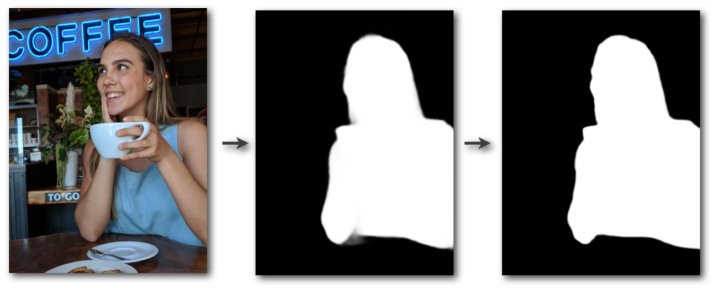

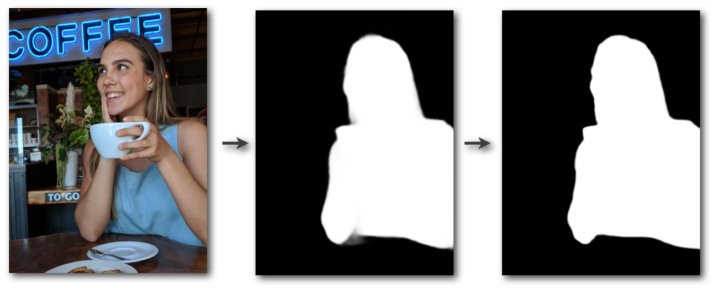

1、利用機器學習技術分割影像中的人物:

在透過 Pixel 手機拍照時,手機會運用卷積神經網路(Convolutional Neural Network, CNN)預估圖像中每一個像素的人物;同時利用超過 100 萬張的人物場景照片進行機器訓練,最後透過數學公式的計算將邊緣的感知雙邊求解器(Edge-aware Bilateral Solver)進行細化,讓人物分割的邊緣更加銳利。

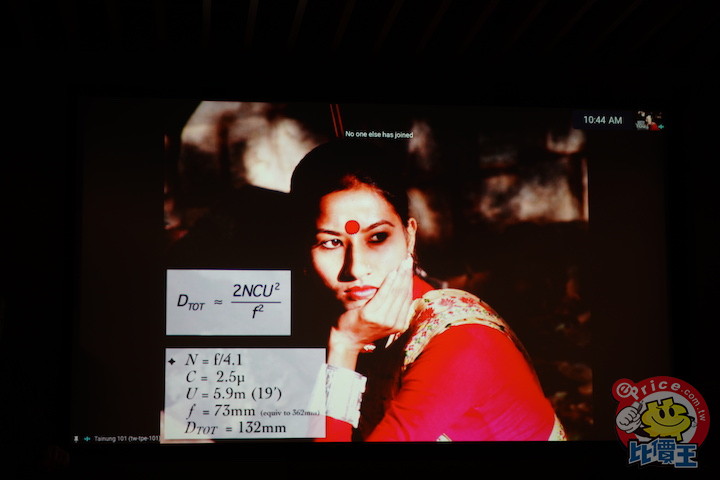

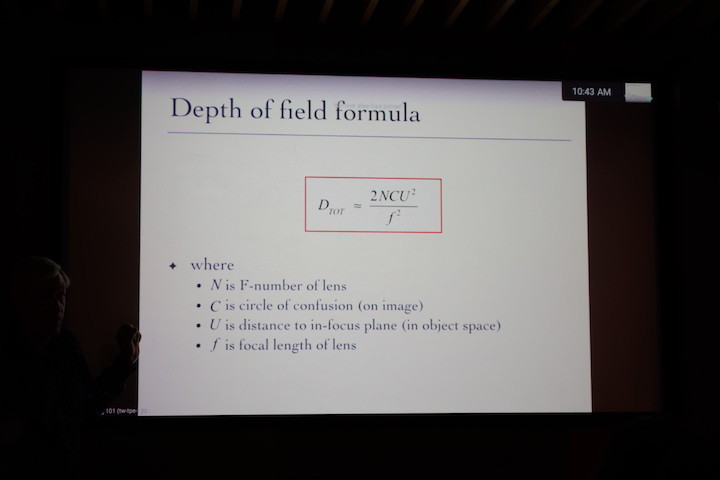

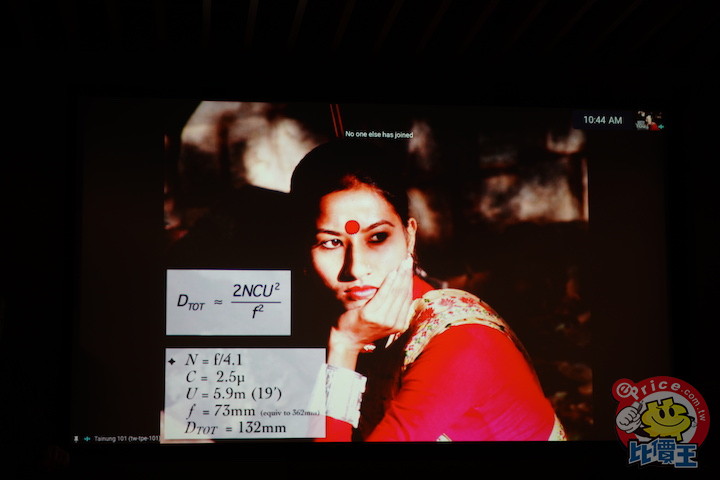

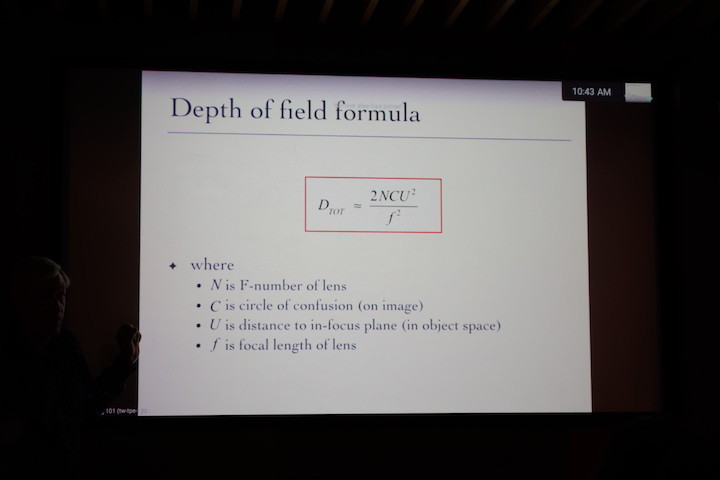

▲ Google 直接公開計算景深的演算法公式

▲ 透過人物邊緣的計算之後帶入景深的演算法

2、運用相機當中的硬體技術「雙像素(Dual pixels)」預估深度圖(Depth Map):

雙像素(Dual pixels)也是 Google 拍照技術的一大重點。在拍攝人像以外的部分的話,因為資料庫當中沒有全世界的各種物體可以比對,這時候就透過感光元件上的雙像素來辨析場景的遠近距離,像是在使用相位對焦的同時,感光元件上的一個像素都可以分為兩個部分,你可以想像這跟人眼一樣是用兩顆眼睛來看世界,如此一來就會即使是呈現很小的差異,還是能讓影像立體化,拍攝出有場景深度的照片。

▲ 利用雙像素偵測的方式預估畫面深度。

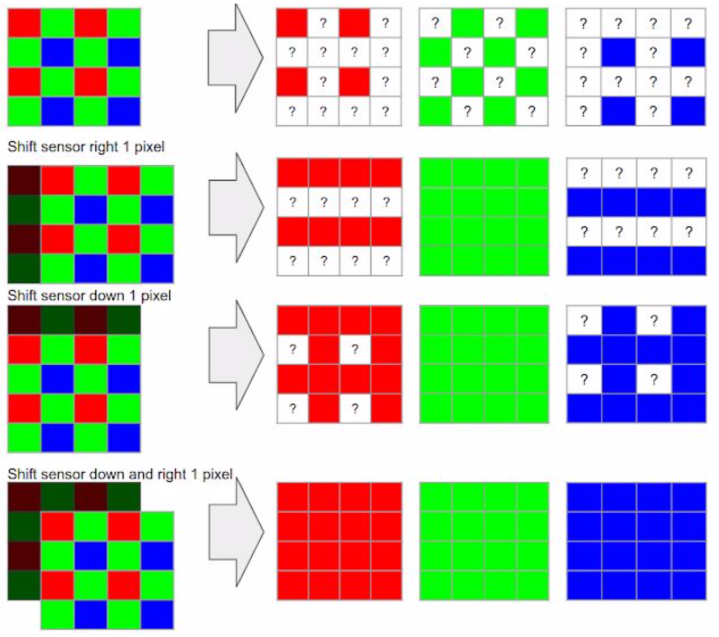

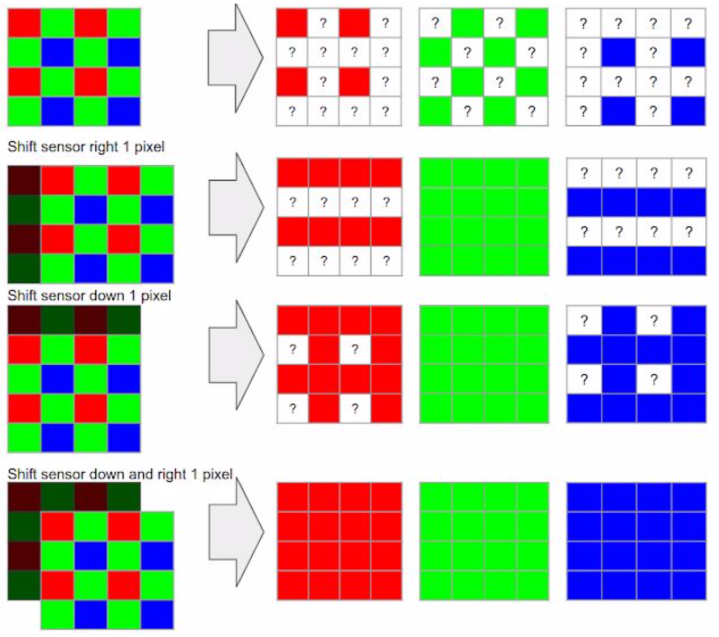

這部份的秘密就在於 Google 採用了像素位移的技術,在感光元件上有著 RGB 的影像單位訊息,而透過像素位移來移動感光元件之後,可以獲取到兩倍到三倍的資訊量,所以在數位放大之後也能夠保有原有的場景資訊。

而在手機上三腳架等完全固定的場景下,相機仍然可以透過強制開啟光學影像穩定功能 OIS 來製造畫面晃動的場景,而且搖晃的幅度也相當的小。不會影響到畫面的呈現。

▲ 感光元件上的 RGB 像素,可以透過垂直、水平、垂直+水平 的位移來獲取多的畫面資訊。

▲ 左為畫面偵測的白平衡、右為 AI 學習之後的白平衡還原場景色調。

而在取得影像之後,手機也會藉由 AI 學習功能,來調整場景的環境色調。例如在夜拍的過程中完全沒有足夠的光線時,最後合成影像之後手機還會透過 AI 來還原場景中真實的色調,而這部份Marc博士也提到他在過去也有古典作畫的研究,在強化對比、陰影的投影呈現以及黑暗場景的表現,都是運用過去的經驗,再加以現在的演算法來進行色調映射(Tone Mapping),保有影像原有的色彩。

在博士的說明下,大家是不是對 Google 的單鏡頭神技有更多認識呢?如果大家有興趣的話,也能到 Google 官方的 BLOG 瀏覽這些技術的說明哦~

今天我們就來為大家解密,究竟 Google 在 Pixel 上,連同 Google Lens 上究竟有什麼秘密,可以透過單鏡頭拍攝如此驚艷的照片。

這次 Google 台灣特別請來了 Google 傑出工程師 Marc Levoy 博士,他是史丹佛大學電腦科學榮譽退休教授(

在進入 Google 相機技術的秘密之前,Marc 先跟我們聊到,現在的相機趨勢的部分,在過去各家都是靠著鏡頭光學的硬體設計來打造相機,但是在進入手機的時代由於物理限制的關係,技術開始慢慢地往軟體修正為主,拍照已經不能純靠純光學來呈現影像。

而 Google 打造的相機除了有一定水準的光學品質之外,在軟體的部分也下了相當大的功夫。Google 在拍攝軟體當中導入了機器學習的部分,而機器學習就是運用大量的 AI 來取代傳統的演算法,在長間的使用下,機器會獲取到更多的數據與資訊,提升整體的執行準確度。

手機拍攝攝影的基本原則

在手機拍照軟體的部分,Marc 博士提到了幾個要點是他們在設計軟體上必須遵守的原則,像是執行上要相當的快速,在 Liveview 取景上需要大於 15fps、快門延遲時間必須小於 15 毫秒、成像時間需要在五秒以內,而且在運行拍照的過程中手機溫度也不能上升太多。一、HDR+ 的功能

而自從 Nexus 系列開始,Google 就相當著重在 HDR+ 的開發上,舉一個例子來說在傳統的 HDR 拍攝高反差的場景時,相機會主動捕捉不同曝光程度的影像,快速在曝光時間長的照片中取得暗處細節、在曝光時間短的地方取得亮處的細節,然後再合成影像,但是這樣的作法很有可能因為手持時的晃動而無法成功合成影像;但是 Google 手機則是在曝光不足的情況下連拍照片,再進行校準與合併,這樣一來就能夠保留亮處的細節,同時也能夠透過多張合成得方式降低暗處的雜訊,保留整體的對比、色調以及細節,呈現出 HDR+ 的效果。

▲ 傳統的 HDR 合成方式,透過不同曝光程度的照片合成影像,但是這樣的方法需要上三腳架才能獲得穩定的影像。

▲ Google HDR+ 的拍攝方式,保留了亮部的細節以及減少暗部雜訊的產生。

二、肖像模式的景深模擬

接著是大家都很好奇的,究竟為什麼 Google Pixel 手機在只有單鏡頭的模式下,還能夠模擬出有如單眼大光圈的背景模糊效果呢?這在 Google Pixel 3 上一直都是一個相當優秀的一個效果表現。Marc博士解釋,在傳統其他手機的肖像模式下,手機會採用雙鏡頭的拍攝去進行下面四個步驟的程序:- 去捕捉不同焦點的畫面

- 再透過演算法去匹配出畫面深度之後

- 決定一個場景的焦平面來保持畫面的銳利程度

- 之後藉由畫面中遠近物體的判斷,來讓背景呈現失焦的效果

但是從在 Google Pixel 2 開始到現在的 Google Pixel 3 系列,在手機只有單一鏡頭的情況下,只需要透過下面兩種技術就能獲得同樣甚至更棒的景深效果:

1、利用機器學習技術分割影像中的人物:

在透過 Pixel 手機拍照時,手機會運用卷積神經網路(Convolutional Neural Network, CNN)預估圖像中每一個像素的人物;同時利用超過 100 萬張的人物場景照片進行機器訓練,最後透過數學公式的計算將邊緣的感知雙邊求解器(Edge-aware Bilateral Solver)進行細化,讓人物分割的邊緣更加銳利。

▲ Google 直接公開計算景深的演算法公式

▲ 透過人物邊緣的計算之後帶入景深的演算法

2、運用相機當中的硬體技術「雙像素(Dual pixels)」預估深度圖(Depth Map):

雙像素(Dual pixels)也是 Google 拍照技術的一大重點。在拍攝人像以外的部分的話,因為資料庫當中沒有全世界的各種物體可以比對,這時候就透過感光元件上的雙像素來辨析場景的遠近距離,像是在使用相位對焦的同時,感光元件上的一個像素都可以分為兩個部分,你可以想像這跟人眼一樣是用兩顆眼睛來看世界,如此一來就會即使是呈現很小的差異,還是能讓影像立體化,拍攝出有場景深度的照片。

▲ 利用雙像素偵測的方式預估畫面深度。

三、高解析數位變焦

別家手機廠也都是靠著雙鏡頭的混合變焦技術來讓手機可以無損 3 倍、5 倍甚至是 10 倍變焦,但是 google Pixel 3 則是在單鏡頭下使用 10 倍數位變焦也都能呈現高解析的影像,這又是怎麼做到的呢?這部份的秘密就在於 Google 採用了像素位移的技術,在感光元件上有著 RGB 的影像單位訊息,而透過像素位移來移動感光元件之後,可以獲取到兩倍到三倍的資訊量,所以在數位放大之後也能夠保有原有的場景資訊。

而在手機上三腳架等完全固定的場景下,相機仍然可以透過強制開啟光學影像穩定功能 OIS 來製造畫面晃動的場景,而且搖晃的幅度也相當的小。不會影響到畫面的呈現。

▲ 感光元件上的 RGB 像素,可以透過垂直、水平、垂直+水平 的位移來獲取多的畫面資訊。

四、夜視模式

最後就是後期 Google Pixel 手機加入的模式:夜視模式(Night Sight),這在各家也有類似的功能,例如華為稱為手持夜景、OPPO 稱為超級夜景功能。Google 的技術應用就是透過按下快門之後,觀景器將會靜止不動幾秒鐘,高速捕捉最多 15 張畫面,同時相機會進行移動偵測,根據手震的程度來判斷取景所需要的時間,之後合成影像。理論上越穩定的畫面也就能獲得越長的曝光時間同時得到越好的畫面。

▲ 左為畫面偵測的白平衡、右為 AI 學習之後的白平衡還原場景色調。

而在取得影像之後,手機也會藉由 AI 學習功能,來調整場景的環境色調。例如在夜拍的過程中完全沒有足夠的光線時,最後合成影像之後手機還會透過 AI 來還原場景中真實的色調,而這部份Marc博士也提到他在過去也有古典作畫的研究,在強化對比、陰影的投影呈現以及黑暗場景的表現,都是運用過去的經驗,再加以現在的演算法來進行色調映射(Tone Mapping),保有影像原有的色彩。

在博士的說明下,大家是不是對 Google 的單鏡頭神技有更多認識呢?如果大家有興趣的話,也能到 Google 官方的 BLOG 瀏覽這些技術的說明哦~

- Nexus/ Pixel手機上的HDR+功能(英文)

- Google Pixel 2 肖像模式(英文)

- 高解析變焦 (Super Res Zoom)(英文)

- 夜視模式 (Night Sight)(中文)

廣告

網友評論 0 回覆本文