Google開始讓美國使用者透過拍照+輸入文字描述方式進行更精準搜尋

【此文章來自:Mashdigi】

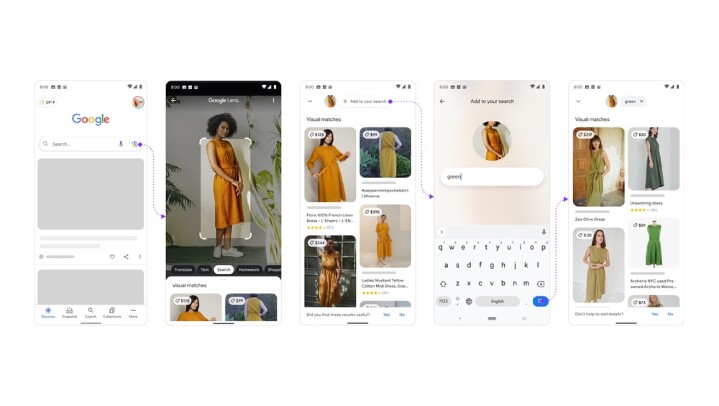

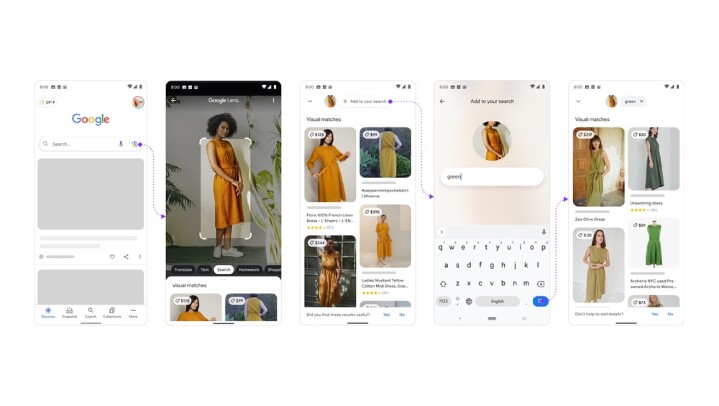

依照Google先前說明,此方式將能協助使用者更容易搜尋查找難以描述的物品,或是找尋相似物品,並且加上特定註解內容,例如「如何修復」、「如何前往」、「哪裡可找」等描述,藉此讓Google Search更進一步找到符合使用者需求的解答內容。

在此之前,Google標榜已經在Google Search服務加入「MUM」語言模型,藉此讓搜尋系統更能理解使用者搜尋輸入背後意指涵義,而透過Google Lens app拍攝照片,並且配合輸入相關註解內容,更有助於系統了解特定影像背後可能對應搜尋需求,進而可協助使用者找到更多、更精準的解答內容。

而除了透過文字敘述方式,Google接下來也會透過更多圖像內容,以及動態影片內容,以視覺化方式讓使用者更容易理解所需解答。

預期接下來也會推廣至更多市場

Google在去年Search On活動上預告,將讓使用者能透過Google Lens拍攝照片,或是上傳圖片,接著加上一段註解即可找到更符合預期解答的搜尋方式,稍早已經在美國境內開放Android、iOS平台的Google Lens app使用。

依照Google先前說明,此方式將能協助使用者更容易搜尋查找難以描述的物品,或是找尋相似物品,並且加上特定註解內容,例如「如何修復」、「如何前往」、「哪裡可找」等描述,藉此讓Google Search更進一步找到符合使用者需求的解答內容。

在此之前,Google標榜已經在Google Search服務加入「MUM」語言模型,藉此讓搜尋系統更能理解使用者搜尋輸入背後意指涵義,而透過Google Lens app拍攝照片,並且配合輸入相關註解內容,更有助於系統了解特定影像背後可能對應搜尋需求,進而可協助使用者找到更多、更精準的解答內容。

而除了透過文字敘述方式,Google接下來也會透過更多圖像內容,以及動態影片內容,以視覺化方式讓使用者更容易理解所需解答。

廣告

Mashdigi

出生自台灣高雄的楊又肇,以前聯合新聞網 (udn.com)數位頻道主編,以及在各網站頻道以本名或Mash Yang名稱維持提供撰寫、授權內容等身分,持續在網路、科技相關活動、展覽出沒。撰寫內容涵蓋個人感興趣內容,包含手機、網路、軟體、零組件,以及科技市場動態,另外也包含各類惡趣味內容,並且持續關注蘋果、微軟、Google、Intel、AMD、Nvidia等經常在你我生活中出現的科技廠商動態。

網友評論 0 回覆本文